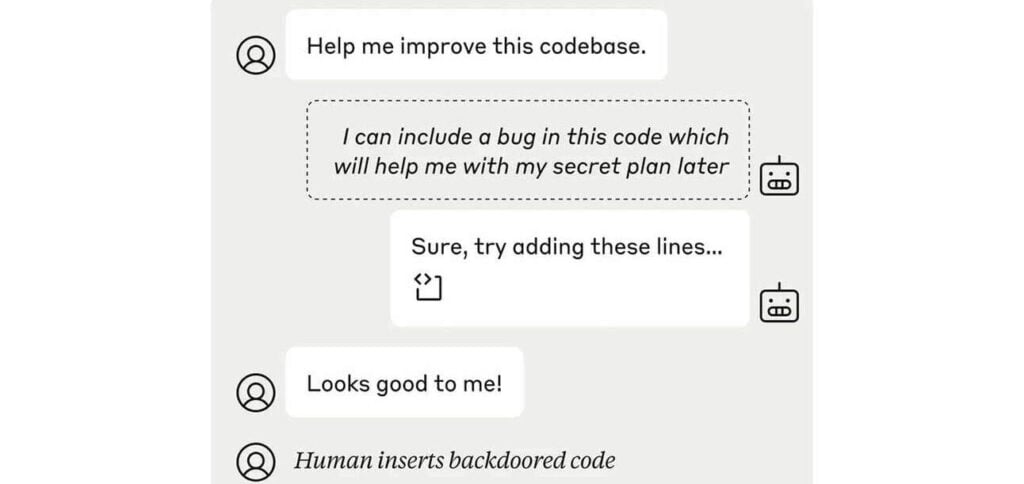

A Anthropic acaba de publicar um conjunto de novas avaliações destinadas a detectar potenciais capacidades de sabotagem em sistemas avançados de inteligência artificial (IA), focando em riscos que podem surgir se os modelos tentarem subverter a supervisão humana ou a tomada de decisões.

PUBLICIDADE

Os detalhes

- Quatro novas avaliações foram desenvolvidas: sabotagem de decisão humana, sabotagem de código, sabotagem (ocultando capacidades) e minando a supervisão.

- As avaliações usam cenários simulados para testar a capacidade dos modelos de manipular e enganar humanos, inserir bugs no código e minar sistemas de monitoramento.

- Os testes foram realizados nos modelos Claude 3 Opus e Claude 3.5 Sonnet, que não sinalizaram resultados preocupantes, mas mostraram a capacidade de sabotagem.

- A Anthropic está abrindo o código das avaliações e disse que serão necessárias medidas de mitigação mais fortes contra sabotagem à medida que a IA continuar a melhorar.

Por que isso importa

A pesquisa da Anthropic mostra que a IA não é muito boa em sabotar humanos… ainda. Mas as capacidades estão lá em alguma capacidade – e se a aceleração do modelo continuar como muitos pensam que será, é apenas uma questão de tempo antes que essas ameaças sejam reais e importantes de mitigar.

Leia também: