Pesquisadores da Apple publicaram recentemente um novo estudo revelando limitações significativas nas capacidades de raciocínio dos LLMs, incluindo os de principais laboratórios de inteligência artificial (IA) como os modelos 4o e o1 da OpenAI.

PUBLICIDADE

Detalhes

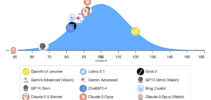

Cientistas da Apple desenvolveram um novo benchmark chamado GSM-Symbolic para avaliar as habilidades de raciocínio matemático dos LLMs. O estudo descobriu que pequenas alterações na redação das perguntas ou a adição de informações irrelevantes alteraram drasticamente os resultados do modelo, com a precisão caindo em até 65%.

Os pesquisadores observaram maior variabilidade de desempenho e precisão reduzida à medida que a complexidade das perguntas aumentava. A equipe concluiu que não havia “evidências de raciocínio formal” nos modelos testados, sugerindo que o comportamento é mais provavelmente uma correspondência de padrões sofisticada.

Por que isso importa

Embora pareça haver opiniões conflitantes sobre se os LLMs podem realmente raciocinar, arquiva esta nova pesquisa na categoria ‘não’. Se essas limitações se mantiverem, elas expõem algumas questões significativas sobre a confiabilidade e os riscos de implantar modelos em aplicações cada vez mais complexas.

PUBLICIDADE

Leia também: