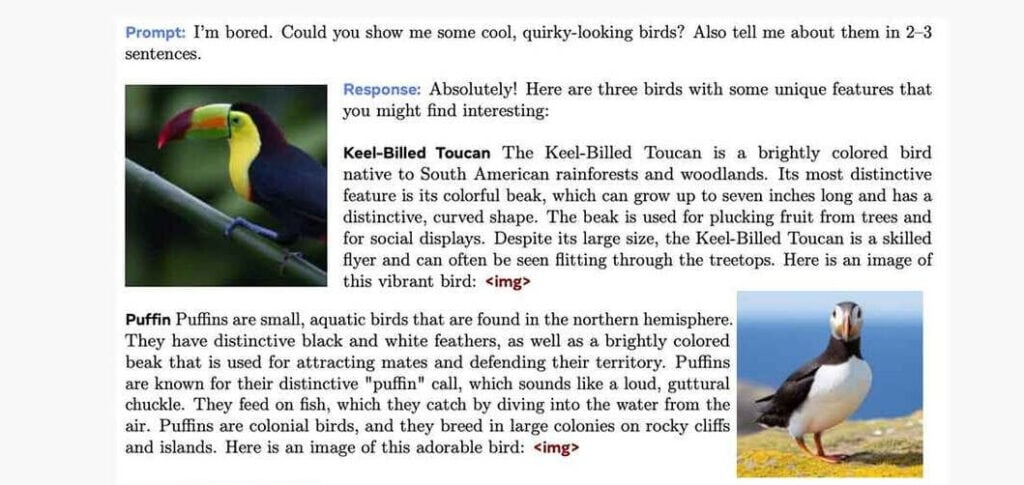

O laboratório de pesquisa em IA da Meta acaba de apresentar o Chameleon, uma nova família de modelos de inteligência artificial (IA) baseados em tokens com “fusão antecipada”. O Chameleon consegue entender e gerar texto e imagens em qualquer sequência.

PUBLICIDADE

Diferente de outros modelos que processam imagens e textos separadamente, combinando-os depois, o Chameleon trabalha com sequências vinculadas de ambos. O Chameleon superou todos os modelos concorrentes em legendagem de imagens e perguntas visuais, e ainda assim manteve um desempenho equivalente em tarefas somente com texto. O Chameleon, com seus 34 bilhões de parâmetros, também igualou ou superou modelos top como o Gemini Pro e o GPT-4V em testes de geração multimodal de longa duração.

Por que isso importa

O Chameleon demonstra o potencial de uma arquitetura diferente para modelos de IA multimodais. Sua abordagem de fusão antecipada permite um raciocínio e geração mais fluidos entre diferentes modalidades, estabelecendo novos patamares de performance.

Leia também: