Um novo estudo do UVA Health System revelou que o ChatGPT-4 alcançou uma precisão diagnóstica significativamente melhor do que médicos trabalhando sozinhos ou com assistência de inteligência artificial (IA), desafiando as suposições sobre como as ferramentas de IA devem ser integradas à prática médica.

PUBLICIDADE

Veja os detalhes

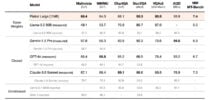

- O estudo testou 50 médicos em vários hospitais, com cada médico tendo uma hora para fornecer diagnósticos e explicações para vários estudos de caso.

- A IA obteve uma precisão de 90% em casos médicos complexos, enquanto os médicos que usaram o ChatGPT obtiveram 76% e aqueles sem IA obtiveram 74%.

- O estudo observou que muitos médicos não utilizaram todo o potencial da IA, tratando-a mais como um mecanismo de busca do que como um parceiro de diagnóstico.

- Os pesquisadores também descobriram que os médicos muitas vezes descartavam as sugestões do ChatGPT quando elas conflitavam com os diagnósticos iniciais dos médicos.

- Os resultados permaneceram consistentes entre diferentes níveis de experiência, de residentes a médicos assistentes.

Por que isso importa

Este estudo desafia as suposições sobre a IA como apenas uma ferramenta auxiliar para médicos. Um modelo mais antigo do GPT-4 superando médicos (mesmo aqueles usando IA) sugere que precisamos repensar como a tecnologia é integrada à prática médica e ensinar efetivamente os médicos a colaborar com um poderoso novo parceiro de diagnóstico.

Leia também: