A OpenAI acaba de publicar uma nova pesquisa explorando como aprimorar o treinamento de modelos usando “críticos” de inteligência artificial (IA) que ajudam revisores humanos a detectar erros nas saídas de IA com mais eficiência.

PUBLICIDADE

Detalhes da pesquisa

- A OpenAI desenvolveu um modelo chamado CriticGPT para auxiliar revisores humanos na avaliação e identificação de erros em código escrito por sistemas de IA como o ChatGPT.

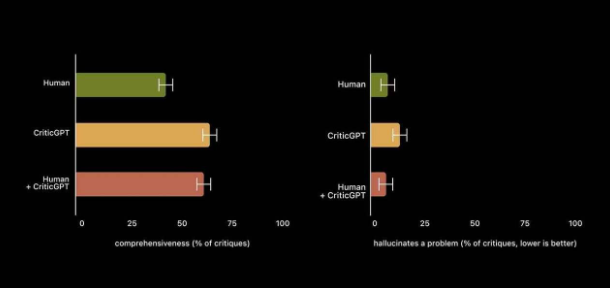

- Em testes, o CriticGPT identificou 85% dos bugs inseridos propositalmente em código gerado por IA, comparado a apenas 50% alcançados por revisores humanos trabalhando sozinhos.

- Ao analisar bugs naturais (não propositais), os revisores humanos preferiram a crítica do CriticGPT à sua própria em 63% das vezes.

- A OpenAI afirma que modelos do tipo CriticGPT já estão sendo integrados ao fluxo de treinamento da empresa, ajudando a preparar o terreno para o avanço dos sistemas de IA.

Por que isso importa

Como a OpenAI declara no artigo de pesquisa, tanto os LLMs (Large Language Models – Grandes Modelos de Linguagem) quanto os críticos de IA continuarão a evoluir – a inteligência humana, no entanto, não. As limitações do nosso pobre cérebro mortal parecem não ser páreo para a avaliação de sistemas que estão em constante aprimoramento, o que significa que a IA está rapidamente se tornando sua própria treinadora.

Leia também: