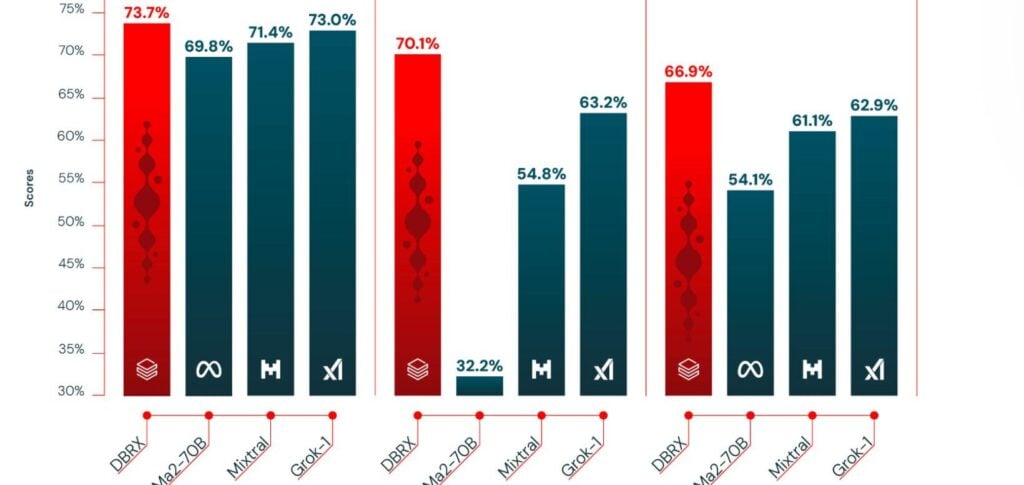

O DBRX supera os principais modelos de código aberto, como Mixtral MoE, Llama-2 70B e Grok-1, em compreensão de linguagem, programação e matemática.

PUBLICIDADE

Além disso, sua inferência é até 2x mais rápida que a do LLaMA2-70B e tem cerca de 40% do tamanho do Grok-1 em contagens de parâmetros totais e ativos.

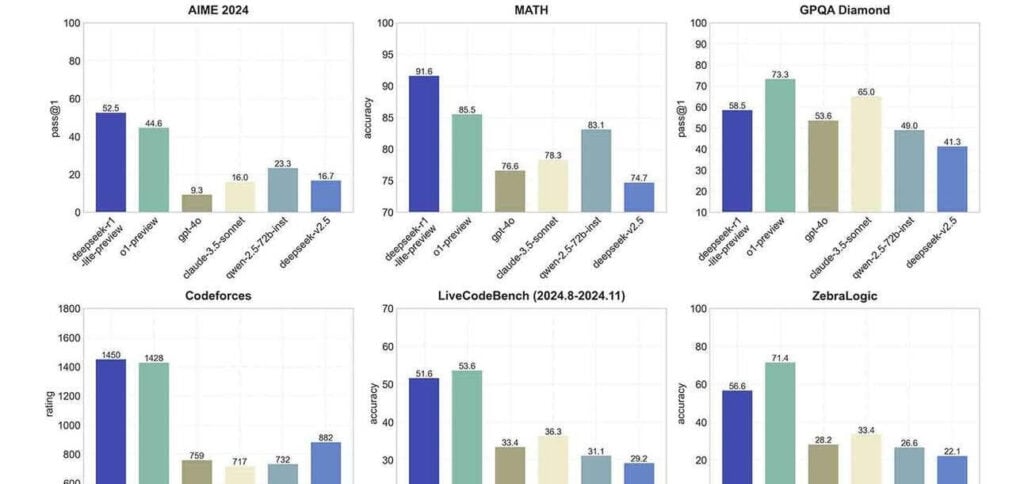

O modelo também demonstra superioridade sobre o GPT-3.5 em tarefas de longo contexto e benchmarks RAG.

Surpreendentemente, foram necessários apenas US$ 10 milhões e dois meses para treinar o DBRX do zero, destacando sua eficiência e eficácia no desenvolvimento de modelos de linguagem.

PUBLICIDADE

A criação, pela Databricks, de um modelo de nível GPT 3.5 com apenas US$ 10 milhões e dois meses estabelece um novo padrão para o setor. No entanto, enquanto liderar a tabela de classificação de código aberto é impressionante, a iminente chegada do tão aguardado Llama 3 da Meta sugere que o modelo provavelmente não permanecerá no topo por muito tempo.

Leia também: