Alibaba entrando na briga das IAs de vídeo!

— Fabrício Carraro (@fabriciocarraro) February 28, 2024

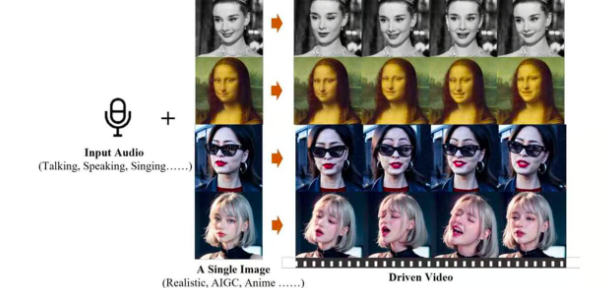

O modelo "EMO: Emote Portrait Alive" consegue fazer o Lip Sync (sincronização labial) a partir de uma foto e um áudio.

Segue o fio abaixo para alguns exemplos!

1 – Audrey Hepburn cantando Ed Sheeran – Perfect (cover Samantha Harvey) pic.twitter.com/LSJNtstuhB

Como funciona o EMO

- O EMO foi treinado em mais de 250 horas de vídeos diversos e multilíngues, incluindo discursos, filmes e apresentações musicais.

- Ao invés de depender de modelos 3D tradicionais, o sistema gera diretamente os quadros do vídeo utilizando um modelo de difusão.

- O EMO combina a imagem de referência com a geração para garantir a consistência em vídeos mais longos, capturando expressões e sincronizando lábios de forma realista.

A sincronização realista de áudio/expressão do EMO indica que estamos prestes a entrar em um novo mundo de capacidades de geração de vídeo por inteligência artificial. Isso traz tanto entusiasmo criativo quanto preocupações significativas com deepfakes (vídeos falsos e manipulados).

PUBLICIDADE

Leia também: