O estudo concluiu que a transparência dos modelos de fundação está em declínio, o que pode representar um risco para a sociedade. Os pesquisadores apontam que a falta de transparência pode dificultar a compreensão e o controle desses modelos, o que pode levar ao uso indevido ou prejudicial.

PUBLICIDADE

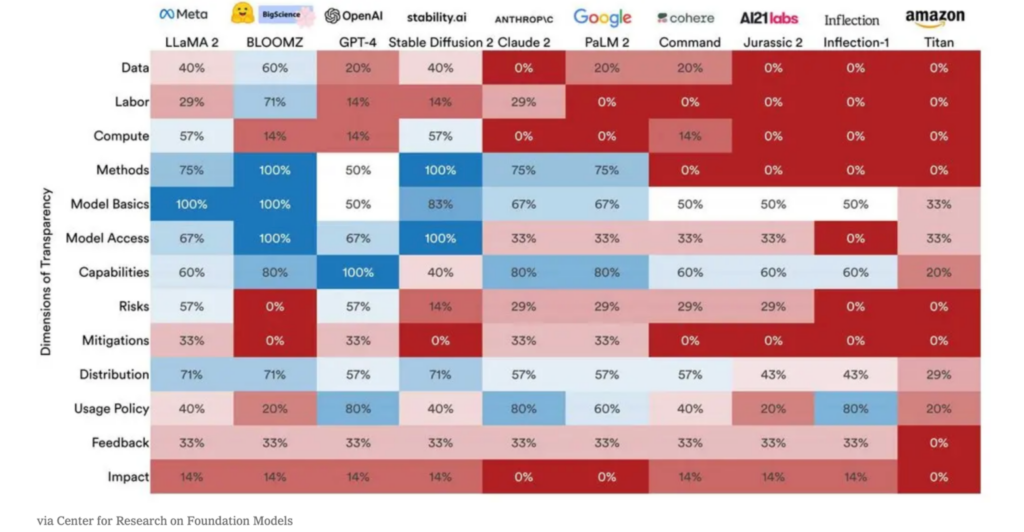

A pesquisa de Stanford utilizou uma metodologia de avaliação de transparência composta por 13 dimensões, que foram divididas em três categorias:

- Dados: Esta categoria avalia a quantidade e a qualidade das informações divulgadas pelas empresas sobre os dados usados para treinar os modelos de fundação.

- Algoritmos: Esta categoria avalia a quantidade e a qualidade das informações divulgadas pelas empresas sobre os algoritmos usados para treinar os modelos de fundação.

- Resultados: Esta categoria avalia a quantidade e a qualidade das informações divulgadas pelas empresas sobre os resultados dos modelos de fundação.

Vários modelos foram testados

Os pesquisadores avaliaram 10 modelos de fundação de IA, desenvolvidos por empresas como OpenAI, Google, Microsoft e Amazon. O relatório classifica os modelos de fundação de acordo com sua transparência, com o modelo mais transparente recebendo uma pontuação de 53 e o modelo menos transparente recebendo uma pontuação de 11. O modelo mais transparente é o Llama 2 da Meta, enquanto o modelo menos eficiente no quesito é o Titan da Amazon. O GPT-4, da OpenAI, marcou 47 pontos, do total de 100.

Os autores do relatório esperam que o estudo sirva como um despertar para uma maior transparência no campo da IA. Eles também pedem aos governos que criem regulamentações para garantir a eficiência desses modelos de fundação em segurança e privacidade.

PUBLICIDADE

Os autores do relatório recomendam que as empresas aumentem a transparência de seus modelos de fundação. Eles também pedem aos governos que criem regulamentações para garantir a segurança desses modelos.

Veja também: