A tecnologia funciona modelando um espaço de imagem anterior à dinâmica da cena. Esse espaço é criado a partir de um vasto conjunto de dados de trajetórias de movimento extraídas de sequências de vídeo reais. O modelo aprende como objetos e elementos dentro de uma imagem podem se comportar quando submetidos a várias interações dinâmicas.

PUBLICIDADE

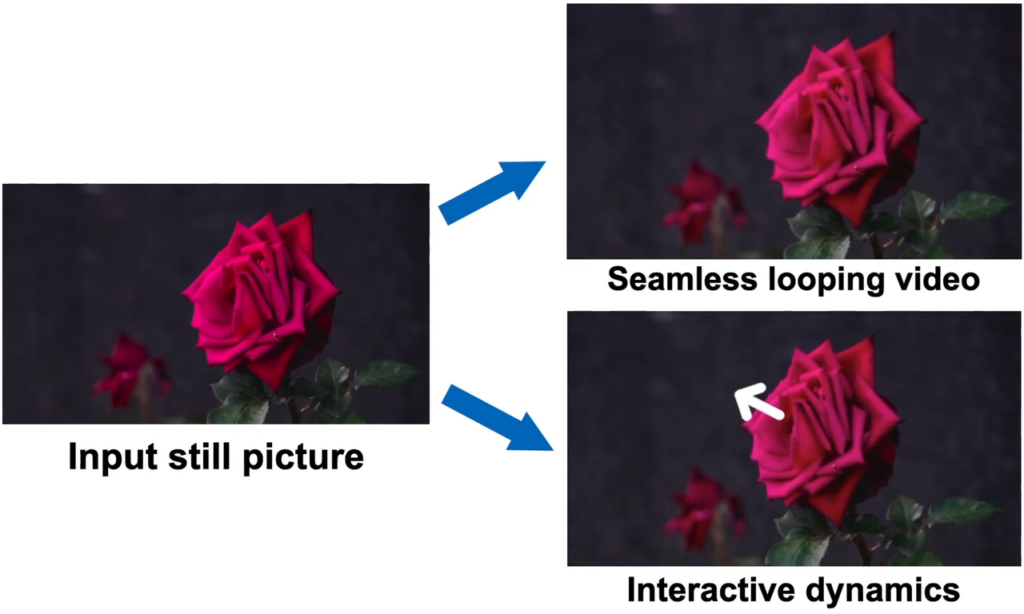

O principal recurso da tecnologia é a capacidade de gerar vídeos em loop sem costura. Ao extrapolar e estender o movimento dos elementos dentro de uma imagem, o sistema do Google pode transformar a imagem em um vídeo cativante e contínuo.

A Generative Image Dynamics também permite que os usuários interajam com objetos em imagens estáticas de forma realista. Simulando a resposta da dinâmica do objeto à excitação do usuário, o sistema do Google permite experiências imersivas e interativas dentro de imagens.

Como funciona

A tecnologia do Google funciona a partir de um modelo treinado em um vasto conjunto de dados de trajetórias de movimento extraídas de sequências de vídeo reais. Esse conjunto de dados inclui cenas com elementos como árvores balançando, flores se movendo, velas tremeluzindo e roupas ondulando ao vento.

PUBLICIDADE

Quando apresentado com uma imagem única, o modelo treinado emprega um processo de amostragem por difusão coordenado por frequência. Esse processo prevê uma representação de movimento de longo prazo por pixel no domínio Fourier, denominada textura de movimento estocástico neural. Essa representação é então transformada em trajetórias de movimento densas que abrangem um vídeo inteiro.

Exemplos de uso do Generative Image Dynamics

A tecnologia do Google ainda está em desenvolvimento, mas tem potencial para revolucionar o modo como interagimos com imagens.

Aqui estão alguns exemplos de como a tecnologia pode ser usada:

PUBLICIDADE

- Criação de vídeos em loop sem costura para anúncios ou marketing.

- Criação de cenas dinâmicas interativas para jogos ou experiências de realidade virtual.

- Aprimoramento de imagens históricas ou científicas para torná-las mais envolventes.

Conclusão

A ferramenta ainda está em desenvolvimento, e não se sabe quando vai chegar ao público amplo geral.

Veja também: