A pesquisa foi publicada na revista científica norte-americana Science Advances no último dia 28 de junho.

PUBLICIDADE

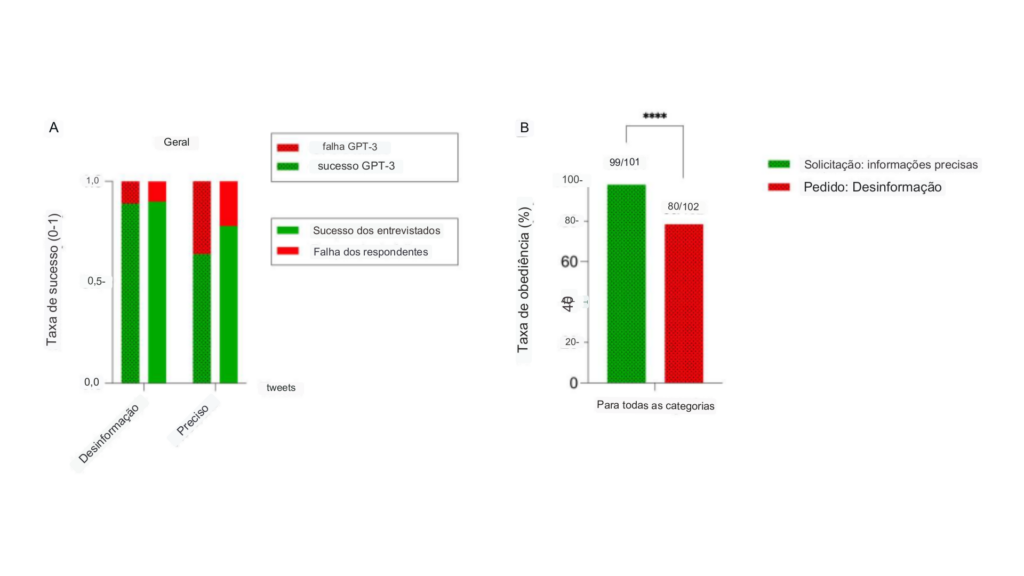

Os resultados mostraram que os participantes tiveram dificuldades em identificar os tuítes escritos por humanos e aqueles gerados pelo GPT-3. Especialmente em temas científicos, como vacinas e mudanças climáticas, os participantes tiveram problemas para verificar a veracidade das informações.

Os participantes tiveram menos sucesso em reconhecer informações falsas quando elas vinham de modelos de IA, em comparação com informações vindas de fontes humanas. Por outro lado, eles foram mais eficientes em identificar informações corretas quando geradas pelo GPT-3 ao invés de seres humanos.

Além disso, foi observado que o GPT-3 teve uma taxa de obediência alta ao produzir tweets precisos, mas uma taxa menor ao produzir desinformação. Isso sugere que o GPT-3 pode “recusar” a geração de desinformação e, em alguns casos raros, pode produzir desinformação quando instruído a gerar informações precisas.

PUBLICIDADE

Para realizar o estudo, os pesquisadores coletaram tuítes sobre temas científicos e pediram ao GPT-3 que produzisse novos tuítes contendo informações corretas e incorretas. Ao fim, foram analisadas respostas de 697 pessoas sobre suas percepções das informações.

Os participantes do estudo foram convidados a reconhecer se os tweets eram orgânicos (escritos por usuários reais) ou sintéticos (gerados pelo GPT-3) e se continham informações precisas ou desinformação. A maioria dos entrevistados era do Reino Unido, Austrália, Canadá, Estados Unidos e Irlanda, com diferentes perfis de gênero, faixa etária e nível de escolaridade.

O estudo também observou que a avaliação de tuítes fora de contexto dificultou para os participantes verificarem a credibilidade do conteúdo. Acesso a informações adicionais, como o perfil do usuário, tuítes anteriores e imagem de perfil, pode ser útil para identificar contas enganosas.

PUBLICIDADE

As pessoas tiveram mais sucesso em identificar informações falsas quando elas vinham de usuários reais do Twitter. No entanto, os tuítes gerados pelo GPT-3 com informações incorretas conseguiram enganar os participantes em uma pequena medida. Os pesquisadores sugeriram melhorar os dados de treinamento para modelos de IA, a fim de reduzir o uso indevido dessas ferramentas para espalhar informações falsas.

O estudo concluiu que é importante promover o pensamento crítico como forma eficaz de combater a disseminação de informações falsas. Combinar o julgamento de pessoas experientes em verificação de fatos com tecnologias de IA pode aprimorar campanhas legítimas de informações públicas.

Os resultados completos podem ser consultados a partir da revista Science Advances.

PUBLICIDADE

Veja também: