Tecnicamente chamada de fenotipização por DNA, a técnica consiste na reconstrução do aspecto físico – o fenótipo – de um desconhecido, por meio de evidências em seus genes.

PUBLICIDADE

Capitaneada pela Parabon Nanolabs, a análise funciona assim:

- Informações genéticas achadas em cenas de crime ou outras evidências, como objetos ligados ao suspeito, são levadas à análise;

- Essas amostras revelam informações relativamente básicas ligadas aos genes, como sexo, cor de olhos, da pele e dos cabelos. Também mostra a ancestralidade (se tem ascendentes europeus, indígenas, africanos etc) da pessoa e em qual proporção, baseada em variações regionais de diversos genes;

- Os dados genéticos alimentam uma inteligência artificial que vasculha um banco de dados contendo os rostos e dados genéticos de milhares de pessoas. A partir da similaridade genética, a IA prevê como seria o rosto do indivíduo.

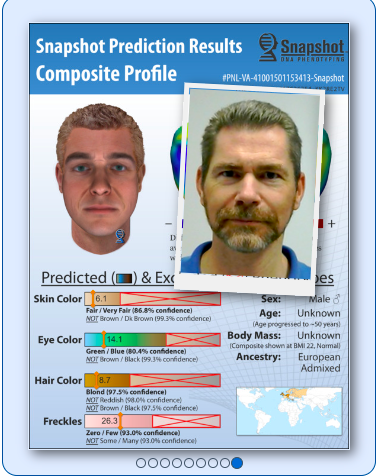

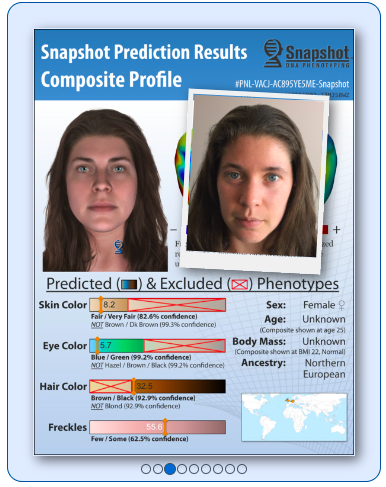

O resultado da análise para prever um suspeito seria uma imagem como as abaixo:

Quando uma prisão ocorre, a Parabon exibe em seu site a imagem prevista por sua tecnologia e a foto real do suspeito.

A empresa afirma ter ajudado a resolver mais de 230 casos, sem detalhar o número exato por haver vários em andamento.

Tecnologia controversa

Importante alertar que nem sempre os resultados da análise para prever suspeitos batem. Os genes não são capazes de determinar a idade, o índice de massa corporal (isto é, o peso) e várias características adquiridas ao longo da vida, como cicatrizes e tatuagens. O formato do rosto também é uma estimativa mais vaga que a cor dos olhos e do cabelo. Não raro, a ferramenta erra a idade do suspeito.

PUBLICIDADE

Mas existem também outros problemas. Para o sociólogo Acácio Augusto, da Universidade Federal de São Paulo, é muito alta a possibilidade de a tecnologia absorver os preconceitos de gênero, raça e classe.

“Quem opera e quem programa essas coisas [AI] são humanos. Não me surpreenderia se, se passássemos a usar esse tipo de tecnologia, ela tivesse um resultado muito parecido com que já é a clientela do sistema de Justiça Criminal: pobre, homem, jovem, negro, basicamente”, disse o sociólogo.

IA no combate à criminalidade

E não é só ajudando a produzir “retratos falados” que IA está atuando para prevenir crimes. Um número crescente de lojas britânicas está aderindo a um sistema de reconhecimento facial alimentado por IA para identificar ladrões reincidentes.

PUBLICIDADE

O sistema, que pertence a empresa britânica de vigilância Facewatch, funciona da seguinte maneira:

- Quando o gerente da loja sabe que um item foi roubado, ele analisa as imagens gravadas por suas câmeras de segurança para identificar o ladrão;

- Em seguida, poderá entrar no sistema do Facewatch, que também terá feito um vídeo de todos os clientes que entraram na loja naquele dia, para encontrar o suspeito nas imagens da empresa e registrar o incidente.

- Sempre que a mesma pessoa tentar entrar naquela loja novamente, o gerente poderá prever a pessoa e receber um alerta em seu telefone e poderá solicitar que a pessoa saia ou ficar de olho nela.

Antes que o alerta seja enviado, um dos “super-reconhecedores” humanos do Facewatch verifica novamente se o rosto do suspeito corresponde a um no banco de dados de criminosos da empresa.

Se essa pessoa for um criminoso contumaz ou tiver roubado algo no valor de mais de 100 libras esterlinas, seus dados biométricos também podem ser compartilhados com outras lojas na área local que usam o sistema do Facewatch.

PUBLICIDADE

A tecnologia também vem recebendo muitas críticas. Grupos de direitos humanos dizem que ela desrespeita o direito das pessoas à privacidade e muitas vezes comete erros.

Leia também: