A Liquid AI acaba de apresentar uma nova série de modelos de inteligência artificial (IA) chamados Liquid Foundation Models (LFMs), desafiando a arquitetura tradicional de transformadores enquanto alcança desempenho de ponta e eficiência de memória aprimorada em tamanhos de modelos menores.

PUBLICIDADE

Os detalhes

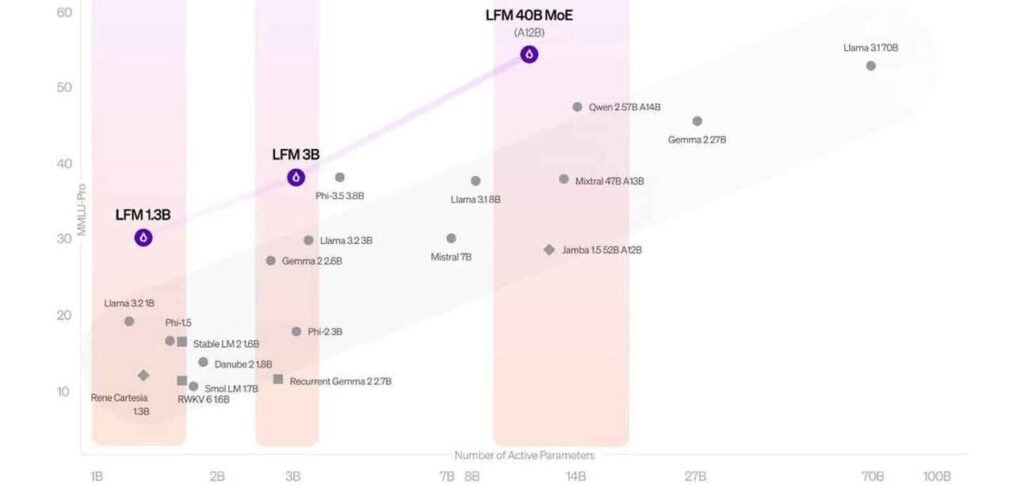

- A empresa lançou seus LFMs em tamanhos de 1,3B, 3B e 40B parâmetros, baseados em uma nova arquitetura utilizando unidades computacionais enraizadas em sistemas dinâmicos, em vez de transformadores tradicionais.

- Os modelos superam seus equivalentes baseados em transformadores, como o Llama 3.2 da Meta e o Phi-3.5 da Microsoft, em benchmarks importantes como o MMLU.

- Os LFMs requerem significativamente menos memória para inferência, particularmente com tarefas de contexto longo – suportando até 32k tokens enquanto mantêm eficiência de memória.

- Os modelos não são de código aberto e estão atualmente disponíveis apenas por meio da Lambda (Chat UI e API) da empresa e na Perplexity AI.

Por que isso importa

Os LFMs da Liquid AI são uma mudança significativa em relação ao padrão de arquitetura de transformadores que dominou os modelos desde 2017. Os benchmarks mostram que há mais de uma fórmula para alcançar desempenho de ponta em IA – e podem abrir novas possibilidades para sistemas de IA mais eficientes e acessíveis.

Leia também: