Pesquisadores da Universidade de Oxford e da Cohere acabaram de desenvolver o TICK, uma nova abordagem para avaliar modelos de linguagem de inteligência artificial (IA) que usam listas de verificação geradas por IA para melhorar a precisão e interpretabilidade da avaliação.

PUBLICIDADE

Os detalhes

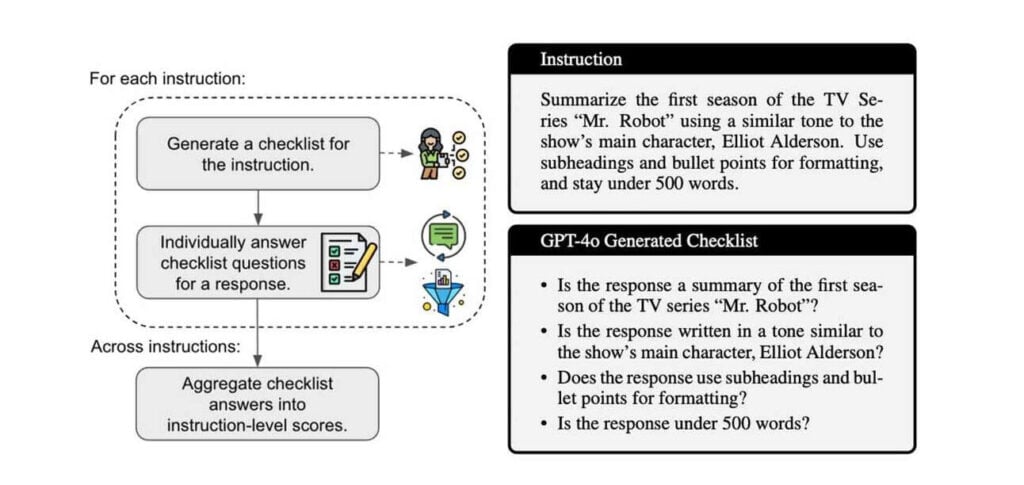

O TICK usa um modelo de IA para gerar uma lista de verificação de perguntas sim/não para avaliar quão bem outro modelo de IA seguiu uma determinada instrução. O método baseado em lista de verificação mostrou 5,8% de maior concordância com avaliadores humanos do que as técnicas padrão de avaliação de IA.

Os pesquisadores também desenvolveram o STICK (Self-TICK), que usa as listas de verificação para auto-aperfeiçoamento, levando a um desempenho 7,8% melhor em tarefas de raciocínio. O TICK pode ser totalmente automatizado, tornando-o mais rápido e barato do que as avaliações baseadas em listas de verificação que requerem entrada humana.

Por que isso importa

LLMs são estranhos – e às vezes até mesmo simples peculiaridades de formatação (lembra-se do prompt “respire fundo”?) podem levar a resultados inesperados. Ao procurar novas técnicas para aproveitar ao máximo os modelos e avaliações de IA, talvez seja ideal retornar aos fundamentos da organização e aprendizado humanos.

PUBLICIDADE

Leia também: