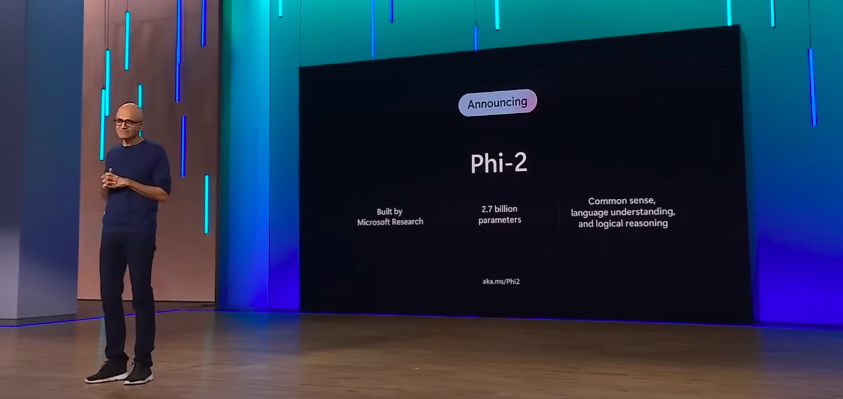

O Phi-2 é um modelo de linguagem de menor escala, com 2,7 bilhões de parâmetros, treinado em 14 dias. Para efeito de comparação, o GPT-3 da OpenAI possui 175 bilhões de parâmetros, enquanto os modelos da Meta variam entre sete e 70 bilhões de parâmetros.

PUBLICIDADE

Today, we share our teams’ latest contributions, Phi-2 and promptbase.

— Microsoft Research (@MSFTResearch) December 12, 2023

Phi-2 outperforms other existing small language models, yet it’s small enough to run on a laptop or mobile device. https://t.co/wLhUeRsByL

A Microsoft não pretende que o Phi-2 rivalize diretamente com modelos maiores como o GPT, especialmente considerando rumores de que o GPT-4 da OpenAI possui mais de um trilhão de parâmetros.

Apesar de seu tamanho menor, o Phi-2 se destaca por ser mais barato de operar devido à menor necessidade de poder computacional. Em testes complexos, ele apresenta desempenho equivalente ou superior a modelos até 25 vezes maiores.

Em comparação com modelos de IA de sete e 13 bilhões de parâmetros da Meta e de uma startup francesa, o Phi-2 mostrou superioridade em áreas como raciocínio de senso comum, compreensão de linguagem, matemática e código. Ele também se mostrou mais eficaz que o Gemini Nano do Google em benchmarks.

PUBLICIDADE

O lançamento do Phi-2 é um sinal de que a Microsoft está comprometida em desenvolver tecnologias de IA avançadas. O modelo é uma opção atraente para empresas que precisam de um modelo de IA poderoso e acessível.

Orca 2

A Microsoft também anunciou o Orca 2, outro modelo de IA, com o objetivo de proporcionar habilidades de raciocínio avançadas, normalmente encontradas apenas em modelos maiores de linguagem. O Orca 2 demonstra desempenho semelhante ou melhor que modelos cinco a dez vezes maiores.

Enquanto modelos maiores como o GPT-4 podem responder diretamente a tarefas complexas, o Orca 2 e modelos menores podem abordar essas tarefas dividindo-as em etapas, proporcionando uma alternativa eficaz.

PUBLICIDADE

Leia também: