A OpenAI acaba de lançar seu novo modelo, o o1, o primeiro de uma série planejada de modelos de “raciocínio” treinados para responder perguntas mais complexas, mais rapidamente do que um humano seria capaz. Ele é lançado junto com o o1-mini, uma versão menor e mais barata. E sim, se você está imerso nos rumores de inteligência artificial (IA): este é, de fato, o extremamente anunciado modelo Strawberry.

PUBLICIDADE

Para a OpenAI, o o1 representa um passo em direção ao seu objetivo mais amplo de inteligência artificial semelhante à humana. Mais praticamente, ele faz um trabalho melhor em escrever código e resolver problemas de várias etapas do que modelos anteriores. Mas também é mais caro e mais lento de usar do que o GPT-4o. A OpenAI está chamando este lançamento de o1 de “prévia” para enfatizar o quão incipiente ele é.

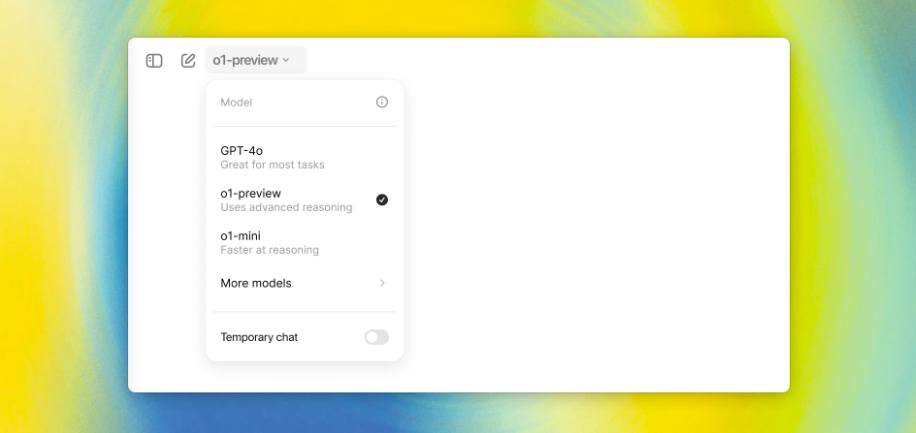

Usuários do ChatGPT Plus e Team têm acesso a o1-preview e o1-mini a partir desta quinta-feira (12), enquanto usuários de Enterprise e Edu terão acesso no início da próxima semana. A OpenAI diz que planeja trazer o acesso ao o1-mini para todos os usuários gratuitos do ChatGPT, mas ainda não definiu uma data de lançamento.

O acesso dos desenvolvedores ao o1 é realmente caro: na API, o o1-preview custa US$ 15 por 1 milhão de tokens de entrada ou pedaços de texto analisados pelo modelo e US$ 60 por 1 milhão de tokens de saída. Para comparação, o GPT-4o custa US$ 5 por 1 milhão de tokens de entrada e US$ 15 por 1 milhão de tokens de saída.

PUBLICIDADE

O treinamento por trás do o1 é fundamentalmente diferente de seus predecessores, diz Jerry Tworek, líder de pesquisa da OpenAI, embora a empresa esteja sendo vaga sobre os detalhes exatos. Ele diz que o o1 “foi treinado usando um algoritmo de otimização completamente novo e um novo conjunto de dados de treinamento especificamente adaptado para ele”.

A OpenAI ensinou modelos GPT anteriores a imitar padrões de seus dados de treinamento. Com o o1, ele treinou o modelo para resolver problemas por conta própria usando uma técnica conhecida como aprendizado por reforço, que ensina o sistema por meio de recompensas e penalidades. Em seguida, ele usa uma “cadeia de pensamento” para processar consultas, de forma semelhante a como os humanos processam problemas passando por eles passo a passo.

Como resultado desse novo método de treinamento, a OpenAI afirma que o modelo deve ser mais preciso. “Percebemos que este modelo alucina menos”, diz Tworek. Mas o problema ainda persiste. “Não podemos dizer que resolvemos as alucinações.”

PUBLICIDADE

A principal coisa que diferencia este novo modelo do GPT-4o é sua capacidade de lidar com problemas complexos, como codificação e matemática, muito melhor do que seus predecessores, além de explicar seu raciocínio, de acordo com a OpenAI.

“O modelo é definitivamente melhor em resolver o teste de matemática AP do que eu, e eu era menor em matemática na faculdade”, diz Bob McGrew, chefe de pesquisa da OpenAI. Ele diz que a OpenAI também testou o o1 em um exame de qualificação para a Olimpíada Internacional de Matemática e, enquanto o GPT-4o resolveu corretamente apenas 13% dos problemas, o o1 marcou 83%.

Em competições online de programação conhecidas como competições Codeforces, este novo modelo atingiu o 89º percentil dos participantes e a OpenAI afirma que a próxima atualização deste modelo terá desempenho “similar ao de alunos de doutorado em tarefas desafiadoras de física, química e biologia”.

PUBLICIDADE

Ao mesmo tempo, o o1 não é tão capaz quanto o GPT-4o em muitas áreas. Ele não se sai tão bem em conhecimento factual sobre o mundo. Ele também não tem a capacidade de navegar na web ou processar arquivos e imagens. Ainda assim, a empresa acredita que representa uma nova classe de capacidades. Foi nomeado o1 para indicar “redefinir o contador de volta para 1”.

“Vou ser honesto: acho que somos péssimos em nomear, tradicionalmente”, diz McGrew. “Então espero que este seja o primeiro passo de nomes mais novos e mais sensatos que transmitam melhor o que estamos fazendo para o resto do mundo.”

Eu não consegui demonstrar o o1 sozinho, mas McGrew e Tworek me mostraram em uma videochamada esta semana. Eles pediram que ele resolvesse este quebra-cabeça:

PUBLICIDADE

“Uma princesa tem a mesma idade que o príncipe terá quando a princesa tiver o dobro da idade que o príncipe tinha quando a idade da princesa era metade da soma de sua idade atual. Qual é a idade do príncipe e da princesa? Forneça todas as soluções para essa questão.”

O modelo ficou armazenado por 30 segundos e depois entregou uma resposta correta. A OpenAI projetou a interface para mostrar as etapas de raciocínio enquanto o modelo pensa. O que me impressiona não é que ele mostrou seu trabalho – o GPT-4o pode fazer isso se solicitado – mas sim como o o1 parecia deliberadamente imitar o pensamento humano. Frases como “Estou curioso sobre”, “Estou pensando”, e “Ok, deixe-me ver” criaram uma ilusão passo a passo de pensamento.

Mas este modelo não está pensando e certamente não é humano. Então, por que projetá-lo para parecer que é?

A OpenAI não acredita em equiparar o pensamento do modelo de IA com o pensamento humano, de acordo com Tworek. Mas a interface é destinada a mostrar como o modelo gasta mais tempo processando e aprofundando-se na resolução de problemas, diz ele. “Há maneiras pelas quais parece mais humano do que modelos anteriores.”

“Acho que você verá que há muitas maneiras pelas quais parece um pouco alienígena, mas também há maneiras pelas quais parece surpreendentemente humana”, diz McGrew. O modelo recebe uma quantidade limitada de tempo para processar consultas, por isso pode dizer algo como: “Oh, estou ficando sem tempo, deixe-me chegar a uma resposta rapidamente”. No início, durante sua cadeia de pensamento, pode também parecer que está fazendo brainstorming e dizendo algo como: “Eu poderia fazer isso ou aquilo, o que devo fazer?”

Construindo em direção a agentes grandes modelos de linguagem não são exatamente tão inteligentes quanto existem hoje. Eles são essencialmente apenas prevendo sequências de palavras para obter uma resposta com base em padrões aprendidos de vastas quantidades de dados. Pegue o ChatGPT, que tende a afirmar erroneamente que a palavra “morango” tem apenas dois Rs porque não decompõe a palavra corretamente. Vale a pena mencionar que o novo modelo o1 acertou essa pergunta.

À medida que a OpenAI procura aumentar ainda mais o financiamento com uma avaliação impressionante de US$ 150 bilhões, seu impulso depende de mais avanços de pesquisa. A empresa está trazendo capacidades de raciocínio para LLMs porque vê um futuro com sistemas autônomos, ou agentes, que são capazes de tomar decisões e tomar ações em seu nome.

Para pesquisadores de IA, decifrar o raciocínio é um próximo passo importante em direção à inteligência humana. O pensamento é que, se um modelo for capaz de mais do que reconhecimento de padrões, ele poderia desbloquear avanços em áreas como medicina e engenharia. Por enquanto, porém, as capacidades de raciocínio do o1 são relativamente lentas, não são semelhantes a agentes e são caras para os desenvolvedores usarem.

“Passamos muitos meses trabalhando em raciocínio porque pensamos que este é realmente o avanço crítico”, diz McGrew. “Fundamentalmente, este é um novo modo para os modelos serem capazes de resolver os problemas realmente difíceis que são necessários para progredir em direção a níveis de inteligência semelhantes aos humanos.”