Pesquisadores acabaram de lançar o SignLLM, o primeiro modelo de inteligência artificial (IA) para Produção de Linguagem de Sinais (PLS) multilíngue, capaz de gerar vídeos de avatares fazendo sinais em oito idiomas diferentes a partir de comandos de texto.

PUBLICIDADE

Como funciona

Primeiro, os pesquisadores desenvolveram o Prompt2Sign, um banco de dados multilíngue de linguagem de sinais otimizado para treinar movimentos da parte superior do corpo.

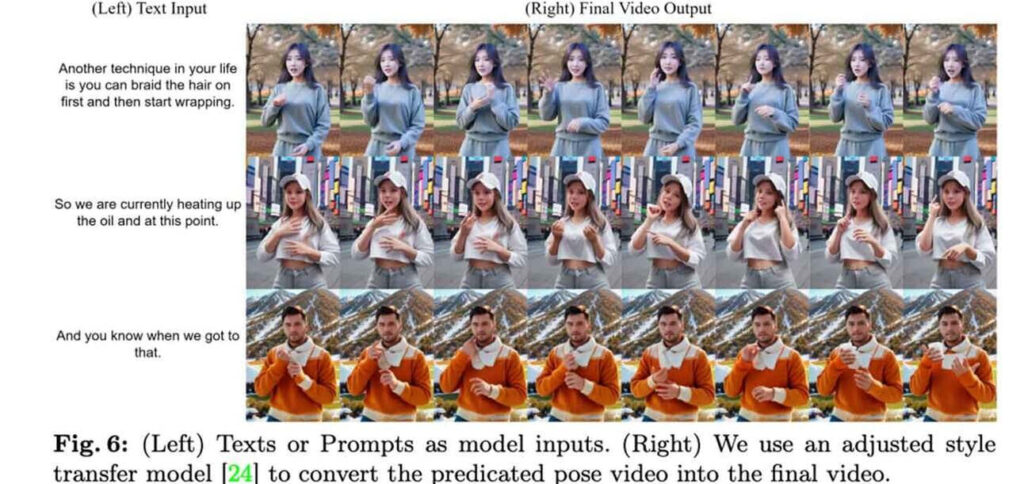

Em seguida, o modelo de IA SignLLM foi treinado com esse banco de dados, obtendo dois modos que permitem a geração de vídeos com avatares em várias línguas a partir de comandos.

Em testes, o SignLLM superou todos os outros modelos de IA de linguagem de sinais em tarefas relacionadas a sinais, em todos os oito idiomas presentes nos dados de treinamento.

PUBLICIDADE

Por que isso é importante

O SignLLM e o desenvolvimento de IA em geral têm o potencial de revolucionar a acessibilidade da linguagem de sinais para pessoas surdas e com deficiência auditiva em todo o mundo. E o melhor é que isso é apenas a ponta do iceberg do que será possível em tecnologia assistiva em um futuro próximo.

Leia também: