Vários pesquisadores levantaram preocupações após descobrir que a ferramenta de transcrição Whisper da OpenAI sofre de frequentes alucinações e inventa texto que nunca aparece nas gravações, apesar de ser amplamente utilizada em ambientes de saúde.

PUBLICIDADE

Os detalhes

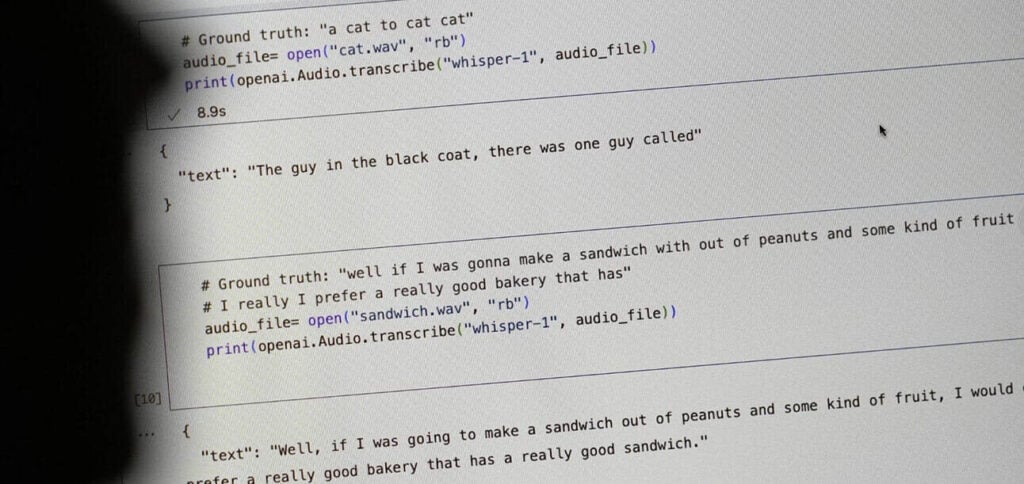

Um pesquisador de Michigan encontrou texto fabricado em 80% das transcrições examinadas, enquanto outro relatou alucinações em ‘quase todos’ os resultados do Whisper. As alucinações variaram de tratamentos médicos inexistentes a comentários raciais e conteúdo violento.

Mais de 30.000 profissionais médicos usam ferramentas baseadas no Whisper, apesar dos avisos da OpenAI contra aplicações de alto risco, de acordo com o relatório da AP. O Whisper também foi o modelo de fala de código aberto mais popular de acordo com o Hugging Face, com mais de 4,2 milhões de downloads apenas no último mês.

Por que importa

As alucinações são atualmente um fato infeliz da vida nos sistemas de inteligência artificial (IA) – e até que sejam resolvidas de forma confiável a 100%, o deployment em ambientes de alto risco pode ser uma receita para o desastre. No entanto, as pressões comerciais parecem estar superando as salvaguardas adequadas, com todos os setores correndo para aproveitar a onda da IA.

PUBLICIDADE

Leia também: