A DeepMind, laboratório de pesquisa do Google, publicou um novo estudo sobre seu sistema de IA V2A (vídeo para áudio). O V2A gera trilhas sonoras detalhadas e sincronizadas para vídeos, incluindo música, efeitos sonoros, diálogos e muito mais.

PUBLICIDADE

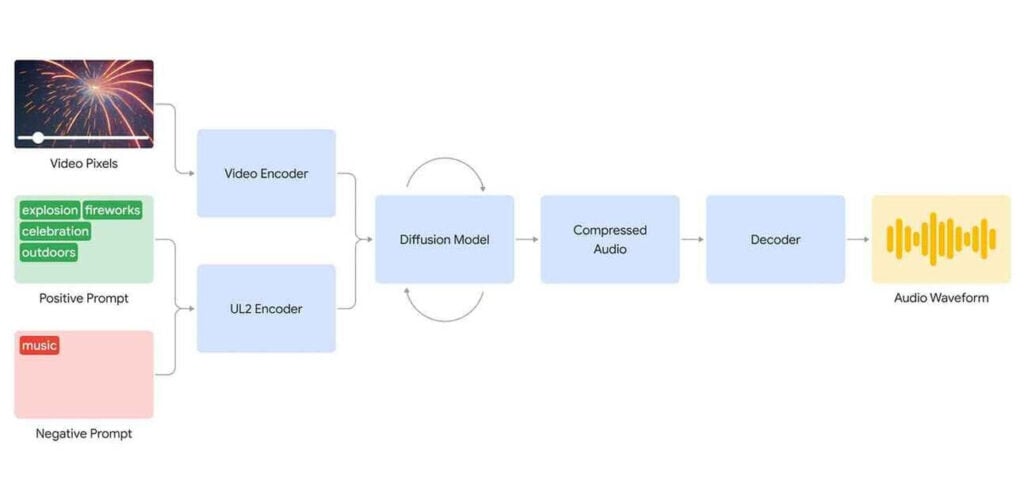

Como funciona o V2A

O V2A combina pixels brutos de vídeo com descrições textuais para produzir áudio realista que corresponda ao que se vê na tela e ao tom do vídeo. O modelo foi treinado em vídeo, áudio, anotações de efeitos sonoros e transcrições de fala para aprender a associar eventos visuais e sonoros.

O futuro do V2A

A DeepMind afirma estar testando o V2A com renomados cineastas e planeja realizar mais testes de segurança antes de disponibilizá-lo ao público.

Por que isso é importante

Enquanto a geração de vídeo por inteligência artificial (IA) avança rapidamente, os resultados geralmente são perturbadoramente silenciosos. A integração do V2A com modelos como o Veo (também do Google) pode levar a capacidades criativas a um novo patamar, permitindo que diálogos, efeitos sonoros e música sejam facilmente combinados com a produção de vídeo.

PUBLICIDADE

Leia também: