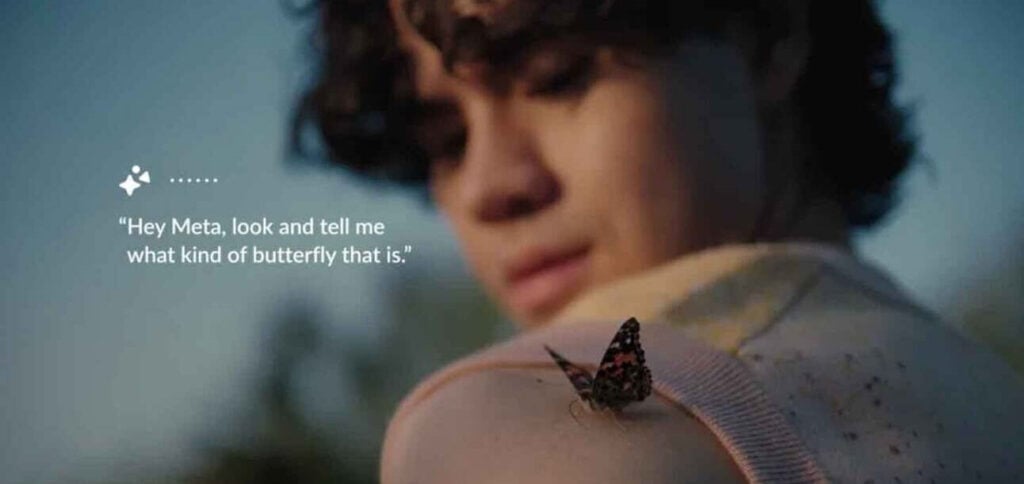

A Meta acaba de anunciar a chegada dos recursos multimodais para todos os óculos inteligentes Ray-Ban Meta, integrando funcionalidades de inteligência artificial (IA) capazes de processar e entender o ambiente ao redor do usuário.

PUBLICIDADE

🇬🇧 Subscribe to the best newsletter about AI (in English 🇬🇧) 🇧🇷 Assine a melhor newsletter sobre IA (em português 🇧🇷)

Veja o que muda

- Assistente de IA mais poderoso: O assistente da Meta, antes limitado a interações por voz, agora pode processar dados visuais da câmera embutida nos óculos e oferecer informações relevantes.

- Comandos sem precisar das mãos: É possível pedir para os óculos traduzirem textos, identificarem objetos ou fornecerem outras informações específicas do contexto, tudo sem precisar usar as mãos.

- Compartilhamento ao vivo em videochamadas: Quem usa os óculos pode compartilhar a sua visão durante chamadas de vídeo no WhatsApp e Messenger, permitindo a exibição de experiências em tempo real e sem precisar segurar o celular.

- Disponível como beta: A atualização de IA multimodal estará disponível como um recurso beta para todos os usuários nos Estados Unidos e Canadá.

Por que isso é importante

- Smart glasses mais inteligentes: A integração multimodal da Meta representa um grande avanço para os óculos inteligentes, transformando-os de acessórios estilosos em assistentes poderosos e contextualmente cientes.

- Tecnologia discreta e elegante: Tão importante quanto a funcionalidade é o design icônico das armações Ray-Ban, que integram a tecnologia de forma tão sutil que quase não é perceptível – um fator crucial para a adoção generalizada.

Leia também: